Bisher erschienene Teile der Blogpostserie

- Teil 1 – Was ist Storage Spaces Direct?

- Teil 2 – Grundlegende Anforderungen für Storage Spaces Direct

- Teil 3 – SSD und NVMe, DWPD, TBW und PBW berechnen und verstehen

- Teil 4 – Netzwerkdesign bei Storage Spaces Direct

In diesem Teil möchte ich ein besonderes Augenmerk auf die Hardwareanforderungen für Storage Spaces Direct legen.

Es ist für den produktiven Betrieb unerlässlich, dass alle Systeme, Komponenten, Geräte und Treiber für Storage Spaces Direct durch Microsoft für den Windows Server 2016 zertifiziert sind.

Unter folgendem Link findet Ihr sogenannte WDDS (Windows Server Software-Defined) Systeme von verschiedenen Herstellern für Storage Spaces Direct. Die dort aufgeführten Hersteller haben ausgewählte Konfigurationen für Storage Spaces Direct bei Microsoft zertifiziert. Vorteil dieser zertifizierten Systeme ist, diese Server sind getestet und zertifiziert, die Hersteller supporten diese Systeme bei Problemen. Nachteil, es stehen nur bestimmte Konfigurationen zur Verfügung, die nur sehr eingeschränkt, wenn überhaupt angepasst werden können.

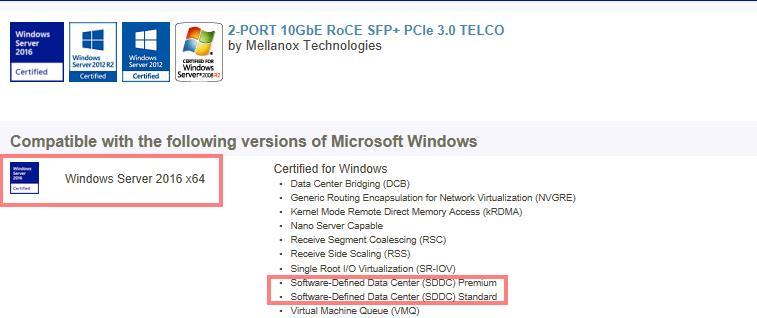

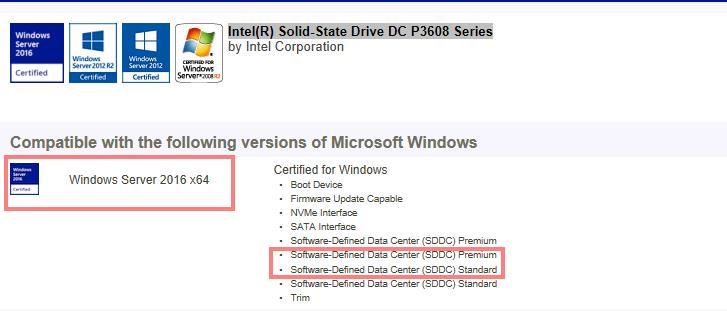

Passt die WDDS Hardware für eure Anforderungen nicht, müsst Ihr die Serversysteme selbst zusammenstellen, dabei ist einiges zu beachten. Oberstes Gebot, alle ausgewählten Komponenten müssen für Windows Server 2016 im Server Catalog und am besten für Software-Defined Data Center (SDDC) Premium oder Standard zertifiziert sein. Die Hersteller müssen die ausgewählten HBAs, Festplatten, NICs usw. in ihren Systemen unterstützen.

hier zwei Beispiele aus dem Windows Server Catalog mit entsprechender Zertifizierung:

Im Folgenden möchte ich die einzelnen Komponenten näher betrachten.

Server:

Es können Standard Server mit bis zu max. 100 TB Devices in einem Server verwendet werden. Storage Spaces Direct kann mit 2 bis max. 16 Servern betrieben werden.

2-Knoten Storage Spaces Direct Failover Cluster:

- Nur 2-Wege Spiegel

- 1 Knoten kann ausfallen

3-Knoten Storage Spaces Direct Failover Cluster:

- 2- Wege und 3-Wege Spiegel (unsere Empfehlung ist immer ein 3 Wege Spiegel einzurichten)

- 1 Knoten und mehrere Festplatte in einem weiteren Knoten können ausfallen

- es dürfen gleichzeitig nicht mehr als die Hälfte aller Festplatten (ohne OS Disks) ausfallen. (Diskmajority)

4-Knoten – 16-Knoten Storage Spaces Direct Failover Cluster:

- 2-Wege und 3-Wege Spiegel (unsere Empfehlung ist immer ein 3 Wege Spiegel einzurichten)

- Single und Double Parity (auch hier ist unsere Empfehlung mit der Double Parity zu arbeiten)

- Hybrid Disk (Mirror und Parity)

- bis zu 2 Knoten können ausfallen oder 2 unterschiedliche Festplatten in unterschiedlichen Servern.

CPU:

- Mindestanforderung ist eine Intel Nehalem CPU oder ein höherer kompatibler Prozessor. Eine AMD EPYC CPU oder ein höherer kompatibler Prozessor

- Bei einer Storage Spaces Direct hyper-converged Lösung sollte darauf geachtet werden, dass die CPU den Anforderungen gemäß größer gewählt wird, da hier der Server nicht nur für die Virtualisierung sondern auch für das Storage genügend Performance benötigt.

Arbeitsspeicherbedarf:

- Pro 1 TB Caching Device müssen 4 GB RAM pro Server zur Verfügung stehen

- Beispielrechnung:2x 3,2 TB Caching Devices => 2 x 3,2 x 4 GB = 25,6 GB RAM

- Zusätzlich muss der Arbeitsspeicherbedarf für die Server, für die VMs oder SQL Workloads berechnet werden. Beachten Sie bitte auch, dass die Server noch genügend Arbeitsspeicher Reserve haben, um beim Ausfall von Failover Clusterknoten die Workloads dieser Server aufnehmen zu können.

Storage Device Anbindung:

Für Storage Spaces Direct benötigen wir zwingend einen Hostbus Adapter (HBA)

- Einfacher Pass-Through SAS HBA für SAS und SATA Devices

- SCSI Enclousure Services (SES) für SAS und SATA Devices

- Jedes Direct-Attached Storage Enclosure muss eine Unique ID präsentieren.

Nicht unterstützt:

- RAID Controller oder SAN (Fibre Channel, iSCSI, FCoE) Laufwerke

- Multipath IO (MPIO) oder physische über mehrere Pfade angebundene Laufwerke

Laufwerke:

Voraussetzungen:

- Jedes Laufwerk muss lokal in einem Server angeschlossen sein

- Als Laufwerkstypen werden SAS, SATA und NVMe unterstützt

- In jedem Server sollten die selben Laufwerke (Typ, Größe, Anzahl, Modell, Firmware) verbaut sein. Ausführliche Infos hierzu findet ihr unter Drive symmetry considerations for Storage Spaces

- Bei den SSDs müssenEnterprise SSDs verwendet werden, die „Power-loss Protection“ unterstützen. Außerdem sollte bei der Auswahl der SSDs genau darauf geachtet werden für welches Einsatzszenario diese benötigt werden. Schreibintensiv, Leseintensiv oder eine Mischung aus Beiden

- Wir werden immer wieder gefragt ob für Storage Spaces Direct nicht auch Consumer SSDs verwendet werden können – ein ganz klares NEIN!!! Es gibt hierzu von Dan Lovinger einen sehr guten Blogbeitrag dazu mit dem Titel: „Don’t do it: consumer-grade solid-state drives (SSD) in Storage Spaces Direct“

- Bei den Cache Laufwerken ist folgendes zu beachten:die SSDs oder NVMe’s sollten einen DWPD (Drive Write per Day) Wert von mindesten 3 haben oder mit 4TB pro Tag beschrieben (TBW) werden können, dieser Wert muss auf die Lebensdauer (meist 5 Jahre) der SSD oder der NVMe berechnet sein. Wie wir anhand der Hersteller Angaben berechnen können, ob die gewünschte SSD oder NVMe den Anforderungen entspricht, darüber mehr in Teil 3.

- Wer nicht solange warten möchte, kann hier schon mal Infos dazu finden.

- Das Betriebssystem sollte auf einem Laufwerk mit Raid1 installiert sein. Vorzugsweise auch auf SSDs. Microsoft gibt 200GB Größe als Empfehlung an.

Unterstütze Laufwerke:

HDD für Kapazität

- 2,5“ und 3,5“ Formfaktor

- Langsam (80 – 200 IOPS) bis 200MB/s Datentransfer

- Günstig

SSD für Performance oder als Cache

- 2,5“ und 3,5“ Formfaktor

- Schnell (Read and Write > 10.000 IOPS) bis 750MB/s Datentransfer

- Teuer

NVMe als Cache oder für Performance

- 2,5“ und PCIe Slot Formfaktor

- Schnell (Reads > 100.000 IOPS) bis 5.000MB/s Datentransfer

- Teuer

Minimunanzahl Laufwerke pro Knoten (ohne die Betriebssystem Festplatten):

- 2 Cache Laufwerke und

- 4 Kapazität Laufwerke

- hier einige Beispiele für die Mindestanforderung der Laufwerke:

Laufwerkstpyen:

- nur NVMe (gleiches Modell)

- nur SSDs (gleiches Modell)

- NVMe + SSD

- SSD + HDD

- NVMe + SSD + HDD

Minimal Anzahl pro Knoten:

- 4 NVMe

- 4 SSD

- 2 NVMe + 4 SSD

- 2 SSD + 4 HDD

- 2 NVMe + 4 Andere

Maximums:

- 100 TB (brutto) Festplattenkapazität pro S2D Knoten

- 1 PB (Petabyte) Brutto Kapazität pro Storage Pool

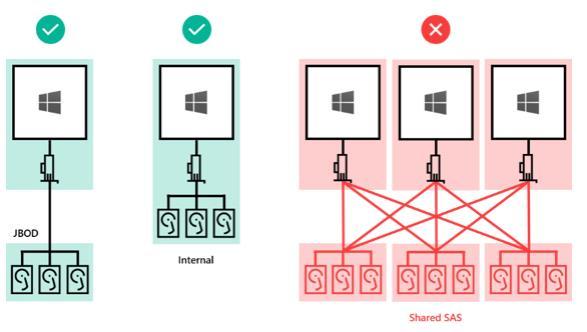

Erweiterung durch JBODs:

- wird grundsätzlich von Microsoft unterstützt.

- Unsere Empfehlung ist: keine JBODS zu verwenden, da diese nur über einen Single Pfad angebunden werden können. Microsoft unterstützt bei Storage Spaces Direct keinMPIO!

- Ein JBOD pro S2D Knoten – kein shared JBOD.

Netzwerk:

- Minimum 10 Gbit für die interne Clusterkommunikation (Ost-West Traffic). Für Performance und Ausfallsicherheit empfiehlt Microsoft hierfür zwei NICs a 10 Gbit zu verwenden.

- Die Netzwerkkarten sollten RDMA (remote direct memory access) mit dem Protokoll RoCE oder iWARP unterstützen.

- Bei einem 2 Knoten Storage Spaces Direct Failover Cluster ist es von Microsoft supported die SMB NICs direkt miteinander zu verbinden (ohne Switche). Bei den WDDS (Windows Server Software-Defined) Systemen muss jedoch darauf geachtet werden, dass auch der Hardware Hersteller dies unterstützt.

- Für die RoCE Konfiguration müssen VLANs angelegt werden, da die Infos zu RoCE im VLAN Header übertragen werden.

- bei den eingesetzten Switche ist eine Unterstützung von PFC (Priority Flow Control) erforderlich , ETS (Enhanced Transmission Selection) wünschenswert .

Im Teil 3 geht es um „SSD und NVMe, DWPD, TBW und PBW berechnen und verstehen“

gutes Gelingen und bis zum nächsten Mal

Petra